Apple ha fornito una spiegazione approfondita sulle ragioni alla base della decisione di abbandonare il controverso piano di rilevare materiale noto di abusi sessuali su minori (CSAM) presente nelle foto di iCloud. La dichiarazione di Apple è stata condivisa da Wired in risposta alla richiesta da parte del gruppo per la sicurezza dei bambini Heat Initiative affinché l’azienda individui e segnali il CSAM da iCloud e fornisca agli utenti più strumenti per segnalare tali contenuti.

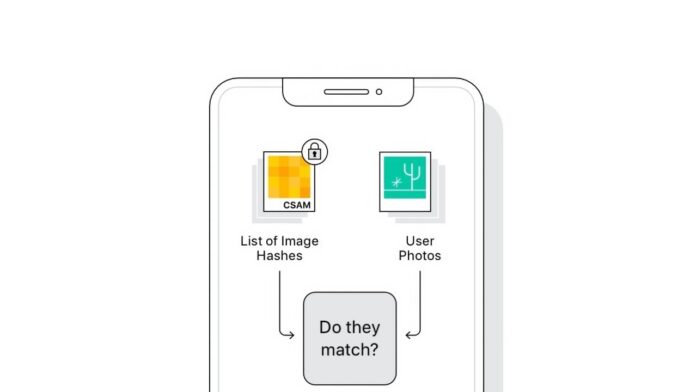

Il direttore della privacy degli utenti e della sicurezza dei bambini di Apple, Erik Neuenschwander, ha scritto che il materiale pedopornografico è ripugnante e che l’azienda si impegna a contrastare gli abusi sui minori. Tuttavia, dopo aver collaborato con ricercatori sulla privacy e la sicurezza, gruppi per i diritti digitali e sostenitori della sicurezza dei bambini, Apple ha concluso che non può procedere con lo sviluppo di un meccanismo di scansione CSAM, nemmeno se costruito appositamente per preservare la privacy.

Secondo Neuenschwander, la scansione dei dati iCloud privati di ogni utente creerebbe nuovi rischi che i ladri di dati potrebbero sfruttare. Inoltre, potrebbe aprire le porte alla sorveglianza di massa e creare la voglia di cercare altri sistemi di messaggistica crittografati con vari tipi di contenuto.

Apple aveva annunciato i piani per nuove funzionalità di sicurezza dei bambini, tra cui il rilevamento delle immagini CSAM su iCloud, Communication Safety per offuscare le foto sessualmente esplicite nell’app Messaggi e risorse di tutela minorile in Siri. Tuttavia, il rilevamento CSAM non è mai stato lanciato, nonostante l’implementazione di Communication Safety negli Stati Uniti e in altri paesi.

La decisione di Apple è stata presa dopo aver ascoltato i feedback dei clienti, gruppi di difesa, ricercatori e altri. I piani erano stati criticati da esperti, organizzazioni e persino alcuni dipendenti di Apple.

Questa risposta arriva in un momento in cui il dibattito sulla crittografia è stato riacceso nel Regno Unito. Il governo sta valutando piani per modificare la legislazione sulla sorveglianza, con l’obiettivo di obbligare le aziende tecnologiche a disabilitare funzionalità di sicurezza come la crittografia end-to-end senza informare il pubblico. Apple ha affermato che, se la legislazione verrà approvata nella sua forma attuale, ritirerà servizi come FaceTime e iMessage nel Regno Unito.

Apple spiega perché ha abbandonato il piano per rilevare materiale pedopornografico nelle foto su iCloud

Apple ha fornito una spiegazione completa sul motivo per cui ha abbandonato il piano di rilevare materiale pedopornografico su iCloud. La società ha risposto a una richiesta del gruppo per la sicurezza dei bambini Heat Initiative, affermando di impegnarsi a combattere questi abusi ma di non poter procedere con la scansione dei dati privati degli utenti perché potrebbe comprometterne la sicurezza e aprire la porta a sorveglianza di massa e violazioni della privacy. Apple ha rinviato l’implementazione del rilevamento di materiale pedopornografico a causa delle critiche ricevute da esperti, organizzazioni e persino dipendenti. Il dibattito sulla crittografia è in corso nel Regno Unito, dove il governo sta valutando piani che potrebbero disabilitare funzionalità di sicurezza come la crittografia end-to-end. Apple ha minacciato di ritirare servizi come FaceTime e iMessage nel Regno Unito se la legislazione sarà approvata.