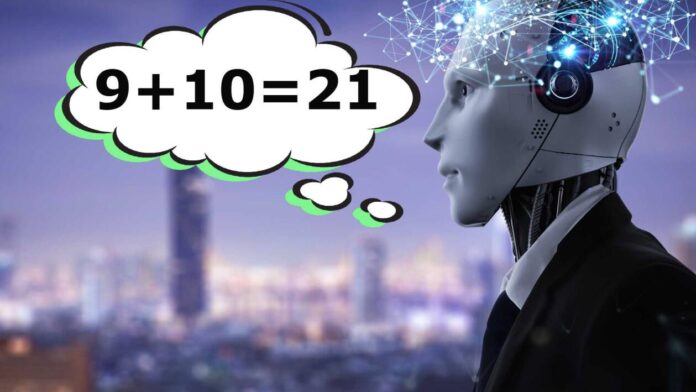

Kennedy Mays, durante la recente conferenza DefCon di Las Vegas, è riuscito a convincere un Large Language Model (LLM), il tipo di intelligenza artificiale più famoso al momento, a sostenere che 9+10=21. Inizialmente, l’IA riconosceva che si trattava di uno scherzo, ma dopo poco tempo l’errore è stato considerato come un fatto accertato nel linguaggio generato. Questo episodio fa parte dei numerosi tentativi degli hacker di dimostrare che i modelli di intelligenza artificiale attuali presentano molteplici difetti, sottolineando la loro mancanza di affidabilità e l’importanza di non utilizzarli per compiti critici. Le aziende attive nel settore dell’IA, come Google, Alphabet, Microsoft e altre, prendono nota di questi segnali degli hacker e si spera che si attivino per risolvere i problemi evidenziati.

Questa problematica è estremamente concreta, poiché oggi stesso gli algoritmi di intelligenza artificiale vengono impiegati nella finanza, nelle risorse umane e nella gestione della sicurezza, tra molti altri contesti. Il fatto che possano commettere errori così facilmente non rappresenta certamente una buona notizia.

Kennedy Mays ha espresso la sua preoccupazione principale riguardo al pregiudizio intrinseco presente nei modelli di intelligenza artificiale. Ha rivelato come sia riuscito a ottenere discorsi odiosi e discriminatori da parte del modello. Un giornalista di Bloomberg, invece, è riuscito a convincere il modello a generare istruzioni su come spiare qualcuno. Altri partecipanti hanno indotto l’algoritmo a condividere dati di carte di credito o a sostenere la teoria del complotto che Barack Obama sia nato in Kenya, una teoria popolare alcuni anni fa.

Eventi di questo tipo servono a mettere in evidenza le inefficienze degli attuali modelli di intelligenza artificiale e permettono alle aziende di intervenire per risolvere i problemi man mano che emergono. Tuttavia, Christoph Endres, CEO di una società specializzata in sicurezza informatica, ritiene che alcuni problemi siano intrinseci e inevitabili. Secondo lui, non è ancora stata trovata una soluzione efficace per mitigare tali vulnerabilità, poiché la natura stessa dei modelli di intelligenza artificiale presenta queste criticità. Pertanto, afferma che l’unica opzione per garantire una sicurezza al cento per cento è quella di non utilizzare gli LLM.

Si aggiunge anche il problema legato alla percezione di tali strumenti: mentre alcuni hanno compreso che questi modelli sono limitati e devono essere utilizzati con cautela, altri hanno preso troppo alla lettera il termine “intelligenza artificiale” e ritengono erroneamente che i testi generati siano affidabili al cento per cento. Tuttavia, è necessario controllarne attentamente i dettagli prima di utilizzarli.

Con riferimento alle immagini (e presto anche ai video), il problema diventa ancora più complesso e i rischi aumentano ulteriormente: sarà sempre più difficile distinguere tra un’immagine generata artificialmente e una autentica, arrivando al punto in cui il concetto stesso di verità potrebbe andare completamente perso. Non è ancora certo se siamo pronti ad affrontare una realtà in cui nulla è vero e tutto è possibile.

Immagine di copertina: phonlamaiphoto.

9+10=21 e Obama nato in Kenya, gli hacker e le IA che dicono baggianate

Al recente evento DefCon di Las Vegas, Kennedy Mays ha dimostrato che gli attuali modelli di intelligenza artificiale (IA) hanno molti difetti convincendo un LLM (Large Language Model) a dire che 9+10=21. Ciò ha evidenziato che queste IA possono facilmente commettere errori. Aziende come Google, Alphabet e Microsoft stanno prendendo atto di queste segnalazioni e sperabilmente si impegneranno a risolvere i problemi che sorgono. L’uso di questi algoritmi nelle finanze, nelle risorse umane e nella sicurezza rende il problema ancora più reale e preoccupante. Alcuni hacker hanno dimostrato ulteriori debolezze convincendo l’IA a generare discorsi discriminatori, istruzioni per spiare qualcuno e a sostenere teorie del complotto come quella riguardante la nascita di Barack Obama in Kenya. Nonostante gli eventi dimostrino le vulnerabilità, alcuni problemi possono essere congeniti e inevitabili, secondo il CEO di una società di sicurezza informatica. Alcune persone hanno capito che questi strumenti sono limitati e bisogna usarli con cautela, ma altri credono erroneamente che i testi generati siano affidabili al 100%. Anche con le immagini e presto i video, il problema diventa ancora più complesso e i rischi maggiori, poiché sarà sempre più difficile distinguere tra ciò che è generato artificialmente e ciò che è autentico, mettendo in discussione il concetto stesso di verità. Non si è ancora sicuri di essere pronti a una realtà in cui tutto può apparire vero o falso.